Aber sie haben auch einen Makel. Festplatten als quasi mechanische Datenträger geben fast immer graduell den Geist auf und kündigen ihr Ableben durch Zunahme defekter Sektoren, Sing- oder Kreischgeräusche oder auffallend hohe Zugriffszeiten an. Man beachte das Kopfbild dieses Blogs. Die Hersteller haben mehrere Jahrzehnte Erfahrung mit der Steuerung der Scheiben und Köpfe, und Datenrettungsfirmen können sie mit Ersatzteilen auslesen oder die Oberflächen der Plattern abtasten.

SSDs hingegen können durch Firmwarefehler spontan das Zeitliche segnen. Im schlimmsten Fall war's das dann, die Platte meldet sich gar nicht mehr. Ob man durch Auflöten eines neuen Controllerchips etwas retten kann? Sehr wahrscheinlich nicht, da der Inhalt fast immer automatisch verschlüsselt wird.

Speichert man Daten auf SSDs braucht man also besonders frische Backups.

Dass solche Ausfälle in der Anfangszeit gelegentlich vorkamen, konnte man verzeihen. Inzwischen, sollte man meinen, haben die Hersteller das im Griff. Doch: Vor einiger Zeit machten Berichte über Probleme mit Samsung-SSDs der 990-Pro-Serie die Runde. Ausgerechnet, denn Samsung hat eigentlich einen guten Ruf.

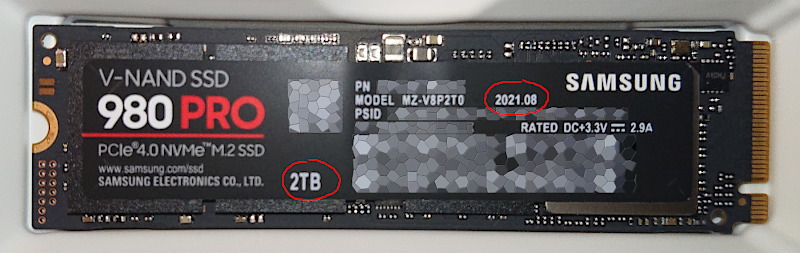

Vor einigen Stunden wurde ich durch ein Video von JayzTwoCents darauf aufmerksam, dass auch die 980-Pro-Serie von Fehlern betroffen ist, sofern das Laufwerk eine Größe von 2TB hat und mit Firmware-Version 3B2QGXA7 läuft. Das ist bei solchen, die 2021 produziert wurden, ziemlich sicher der Fall.

Die fehlerhafte Firmware registriert irrtümlich Speicherblöcke als defekt und sperrt irgendwann das Laufwerk gegen Schreibzugriffe. Irreversibel. Hässlich. Aber: Ein rechtzeitiges Firmware-Update kann Probleme vermeiden.

Da fiel mir der kleine schwarze Karton ein, der nur wegen Zeitmangel noch ungeöffnet bei mir herumliegt. Mal reingucken...

Ups! In wenigen Tagen hätte ich nichtsahnend die SSD verbaut und vermutlich nicht als erstes die Firmware aktualisiert. o.O